Представьте: вам нужно проанализировать тысячи товаров конкурентов, собрать отзывы клиентов или обновлять базу данных ежедневно.

Вручную это займёт недели, а иногда и месяцы. Но такие задачи можно решить за часы — с помощью парсинга сайтов.

Что такое парсинг и зачем он нужен?

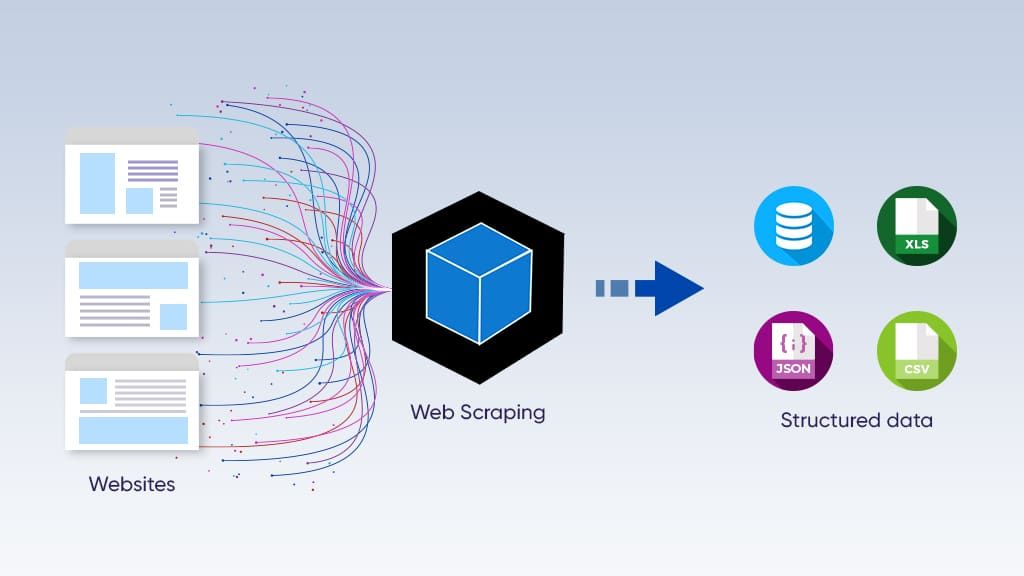

Парсинг (или веб-скрапинг) — это автоматизированный сбор данных с сайтов. Специальные скрипты или программы анализируют HTML-код страницы и вытягивают нужную информацию: можно делать парсинг цен, текстов, контактов, изображений, статей, вакансий — всё, что доступно в открытом доступе.

Почему это важно для IT-специалистов и стартапов?

- Экономит время и силы. Тысячи строк кода за секунды делают работу, на которую вручную ушли бы месяцы.

- Помогает принимать решения. Можно анализировать конкурентов, изучать отзывы, отслеживать рыночные тренды.

- Автоматизирует рутину. Мониторинг цен, обновление каталогов, анализ новостей — всё это можно делать без участия человека.

Где применяют парсинг?

1. Анализ конкурентов

Стартапам важно понимать, чем занимаются конкуренты. Парсинг помогает отслеживать:

- Цены и скидки в e-commerce.

- Ассортимент товаров и услуг.

- SEO-стратегии (ключевые слова, метатеги).

- Отзывы пользователей.

Сервис доставки еды может анализировать меню ресторанов, чтобы предлагать пользователям лучшие варианты.

2. Сбор данных для машинного обучения

Данные это основной источник информации для AI. Парсинг помогает собирать датасеты для:

- Анализа текстов (новости, отзывы, комментарии).

- Компьютерного зрения (изображения товаров, лица).

- Прогнозирования (цен, спроса, поведения пользователей).

Стартап, разрабатывающий чат-бота, может парсить форумы и соцсети, чтобы улучшать понимание естественного языка.

3. Интеграция с внешними сервисами

Не у всех сайтов есть API, а если и есть — оно может быть платным. Парсинг решает эту проблему.

Туристическое приложение может собирать расписания рейсов с сайтов авиакомпаний, чтобы показывать актуальную информацию.

4. Мониторинг и оповещения

Автоматизированный парсинг помогает отслеживать изменения на сайтах и сразу реагировать:

- Падение цен у конкурентов.

- Новые негативные отзывы.

- Обновления законодательных документов.

IT-компания может следить за вакансиями конкурентов, чтобы корректировать зарплатные предложения.

Какие инструменты использовать?

Выбор зависит от задач и навыков. Для новичков: Beautiful Soup + Python. Это простой способ парсить статические сайты.

Для больших проектов: Scrapy — мощный фреймворк с поддержкой асинхронных запросов.

Для динамических сайтов: Selenium эмулирует поведение пользователя в браузере.

Для тех, кто не хочет кодить: Octoparse, ParseHub. Это готовые сервисы с визуальным интерфейсом.

Для обхода блокировок: Bright Data, ScraperAPI помогают справляться с защитой сайтов.

Типичные проблемы парсинга и их решения

При автоматизированном сборе данных часто возникают блокировки IP — сайты воспринимают частые запросы как атаку. Решение: ротация прокси и настройка задержек между запросами.

Динамический контент, загружаемый через JavaScript, не виден в исходном коде. Для работы с ним нужны headless-браузеры типа Puppeteer или Playwright.

Капчи блокируют автоматический сбор. Обойти их помогают сервисы вроде Anti-Captcha или кастомные ML-модели.

Юридические риски минимизируются проверкой robots.txt и соблюдением условий использования сайта. Некоторые ресурсы явно запрещают парсинг в пользовательском соглашении.

Заключение

Парсинг — это не просто инструмент для айтишников. Это способ ускорить рост стартапа, анализировать рынок, находить клиентов и тестировать идеи. Главное — использовать его этично и соблюдать правила сайтов.