Вы устали тратить непомерные суммы на модели ИИ, такие как O1 от OpenAI, для сложных задач рассуждения? Представьте себе, что вы запускаете мощную модель рассуждения локально на своей машине за малую часть стоимости или даже бесплатно. Добро пожаловать в мир DeepSeek-R1 — революционной модели с открытым исходным кодом, которая предлагает возможности, сопоставимые с возможностями O1 от OpenAI, но с гораздо большей гибкостью и бесплатно. В этой статье я расскажу вам обо всем, что вам нужно знать для локальной настройки DeepSeek-R1, о необходимых вам инструментах, процессе установки и невероятных преимуществах, которые она предлагает для ваших проектов.

Что такое DeepSeek-R1?

Прежде чем погрузиться в процесс установки, важно понять, что такое DeepSeek-R1 и как он может вам помочь. DeepSeek-R1 — это модель рассуждений с открытым исходным кодом, разработанная для воспроизведения высокоуровневых возможностей модели OpenAI O1. В то время как большинство традиционных больших языковых моделей (LLM) дают быстрые ответы на основе обученных наборов данных, модели рассуждений, такие как DeepSeek-R1, выходят за рамки простого распознавания образов. Эти модели имитируют более вдумчивый, пошаговый процесс рассуждений, предоставляя более точные и надежные ответы.

Такой подход делает DeepSeek-R1 идеальным для сложных задач, таких как планирование, устранение неполадок и работа со сложным кодом, математикой или головоломками. Запустив DeepSeek-R1 локально, вы получаете возможность тестировать его на своем оборудовании, экономя деньги и получая высокоуровневые возможности ИИ.

Кому принадлежит DeepSeek

DeepSeek — китайская компания в области искусственного интеллекта, основанная в 2023 году Ляном Вэньфэном, который также является ее генеральным директором. Компания принадлежит и финансируется исключительно китайским хедж-фондом High-Flyer, соучредителем которого является Лян Вэньфэн. Название компании на родном языке: (杭州深度求索人工智能基础技术研究有限公司) Hangzhou Deep Search Artificial Intelligence Basic Technology Research Co., Ltd.

Зачем запускать DeepSeek-R1 локально?

Локальный запуск DeepSeek-R1 на вашем компьютере обеспечивает ряд преимуществ:

- Экономия средств: стоимость O1 от OpenAI может достигать 60 долларов за миллион токенов, в то время как DeepSeek-R1 бесплатен и имеет открытый исходный код, что позволяет избежать высоких комиссий за использование API.

- Настройка: Запустив его локально, вы получаете полный контроль над моделью. Вы можете настроить его для конкретных случаев использования, интегрировать с существующими рабочими процессами и оптимизировать производительность для своих нужд.

- Безопасность и конфиденциальность: запуск модели на вашем компьютере означает, что конфиденциальные данные никогда не покинут вашу среду, что обеспечивает лучшую безопасность и конфиденциальность.

- Более быстрое время отклика: нет необходимости полагаться на облачные серверы. Запустив DeepSeek-R1 локально, вы можете ожидать более быстрого времени вычислений, особенно для сложных задач рассуждения.

Технические характеристики для локального запуска DeepSeek-R1

Для локального запуска DeepSeek-R1 ваша система должна соответствовать определенным требованиям к оборудованию и программному обеспечению. Вот список того, что вам понадобится:

Требования к оборудованию

- Графический процессор: высокопроизводительный графический процессор с объемом видеопамяти не менее 16 ГБ (например, NVIDIA RTX 3090 или A100).

- ЦП: многоядерный процессор (например, Intel i7 или AMD Ryzen 7).

- Оперативная память: минимум 32 ГБ, хотя для больших наборов данных рекомендуется 64 ГБ.

- Хранилище: не менее 100 ГБ свободного места на SSD-диске для весов моделей и наборов данных.

Требования к программному обеспечению

- Операционная система: Linux (Ubuntu 20.04 или более поздняя версия) или Windows 10/11 с WSL2.

- Python: версия 3.8 или выше.

- CUDA: версия 11.2 или выше для ускорения графического процессора.

- Фреймворк глубокого обучения: PyTorch или TensorFlow, в зависимости от ваших предпочтений.

Теперь, когда мы рассмотрели, почему выгодно запускать DeepSeek-R1 локально, давайте рассмотрим, как это можно сделать.

1. Шаги для локального запуска DeepSeek-R1 (метод Оллама)

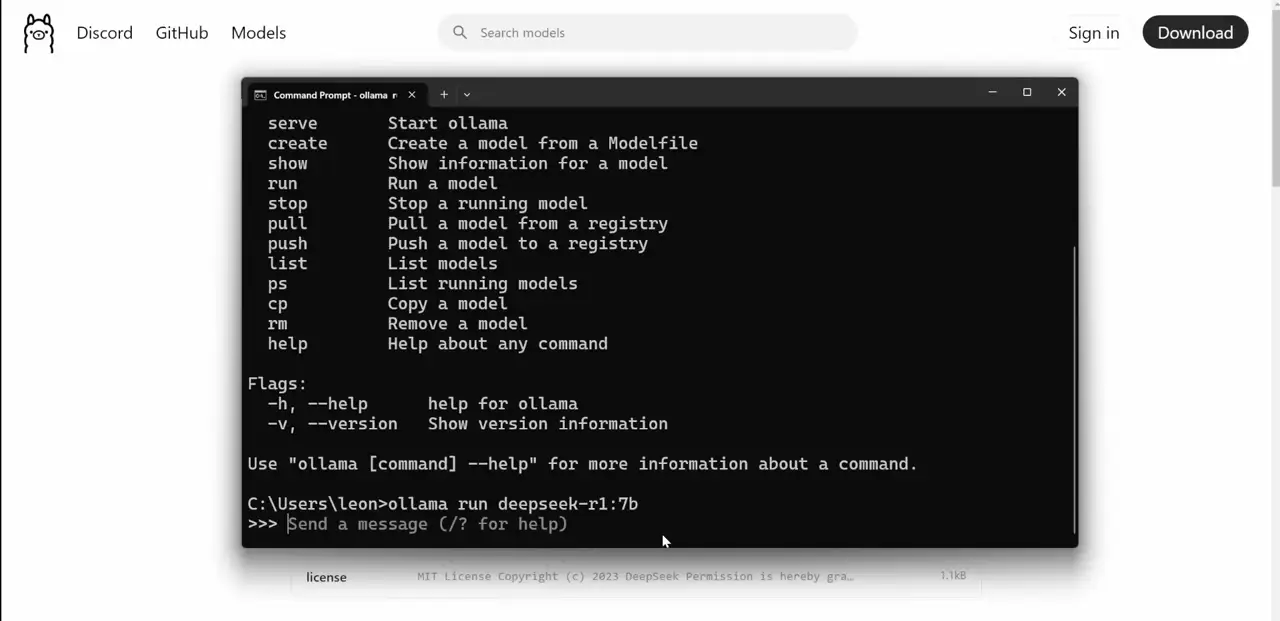

Шаг 1: Установка Олламы

Ollama — это легкий инструмент, который позволяет легко запускать большие языковые модели, такие как DeepSeek-R1, на вашей собственной машине. Он бесплатный и совместим с различными операционными системами, включая Windows, Mac и Linux. Выполните следующие шаги для установки Ollama:

- Загрузите Ollama: посетите официальный сайт Ollama и загрузите установщик для вашей операционной системы.

- Установите Ollama: запустите загруженный установщик и следуйте инструкциям на экране для завершения установки.

- Проверьте установку: после завершения установки откройте командную строку или терминал и введите

ollama. Если установка выполнена правильно, вы увидите список доступных команд.

Шаг 2: Загрузите модель DeepSeek-R1

Установив Ollama, вы теперь можете загрузить модель DeepSeek-R1. Вот как это сделать:

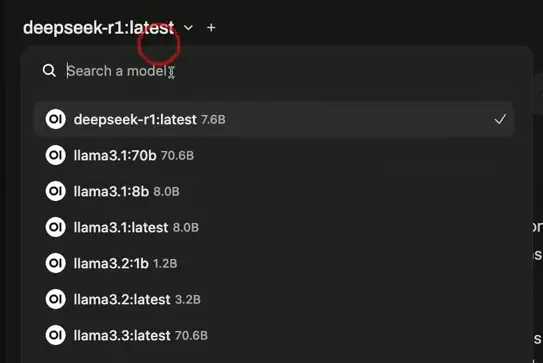

- Перейдите в раздел моделей на сайте Ollama.

- Найдите DeepSeek-R1 и выберите версию, которая подходит вашему оборудованию. Модели с 1,5 миллиардами или 7 миллиардами параметров идеально подходят для большинства установок.

- Скопируйте команду загрузки для выбранной вами модели и вставьте ее в терминал или командную строку.

- Начнется загрузка модели, и после ее завершения она будет готова к использованию.

Шаг 3: Запустите DeepSeek-R1 локально

Теперь, когда DeepSeek-R1 загружен, вы можете начать использовать его для решения сложных логических задач.

- Откройте терминал или командную строку.

- Введите простую команду, например,

ollama deepseek-r1 helloдля проверки модели. Вы увидите, как модель начинает свой процесс рассуждения шаг за шагом. - По мере обработки подсказки модель будет давать более содержательный ответ по сравнению с традиционными LLM, демонстрируя по ходу дела ход своих рассуждений.

Основные характеристики и характеристики DeepSeek-R1

| Особенность | Особенность 2 | Особенность 3 | Особенность 4 |

|---|---|---|---|

| Бесплатное использование | Доступность открытого исходного кода | Работает локально на вашем компьютере | Гибкие размеры моделей |

| Пошаговое рассуждение | Подробные объяснения процесса | Мощный для сложных задач | Поддерживает интеграцию с N8N и Flowwise AI |

| Различные размеры моделей | Параметры от 1,5B до 671B | Идеально подходит для программирования, математики и головоломок. | Безопасно и конфиденциально |

2. Пошаговое руководство по локальному запуску DeepSeek-R1 (локальное развертывание модели)

Шаг 1: Настройте свою среду

Первый шаг — подготовить систему к запуску DeepSeek-R1. Это включает установку необходимого программного обеспечения и зависимостей.

1. Установите Python и Pip: Убедитесь, что у вас установлен Python 3.8 или выше. Вы можете загрузить его с официального сайта Python.

2. Настройте виртуальную среду: используйте venvили, condaчтобы создать изолированную среду для вашего проекта.

python -m venv deepseek-env

source deepseek-env/bin/activate

3. Установите PyTorch или TensorFlow: в зависимости от ваших предпочтений установите фреймворк глубокого обучения.

pip install torch torchvision torchaudio

4. Установите дополнительные зависимости: установите библиотеки, такие как NumPy, Pandas и Transformers.

pip install numpy pandas transformers

Шаг 2: Загрузите веса модели DeepSeek-R1

Далее вам нужно будет загрузить веса модели DeepSeek-R1. Обычно они доступны из официального репозитория или надежного источника.

1. Клонируйте репозиторий: используйте Git для клонирования официального репозитория DeepSeek-R1.

git clone https://github.com/deepseek-ai/DeepSeek-R1.git

cd DeepSeek-R1

2. Загрузите веса моделей: следуйте инструкциям в репозитории, чтобы загрузить предварительно обученные веса.

Шаг 3: Настройка модели

После загрузки весов вам необходимо настроить модель для вашего конкретного варианта использования.

1. Загрузите модель: используйте следующий код для загрузки модели в PyTorch.

from transformers import AutoModel, AutoTokenizermodel = AutoModel.from_pretrained("путь_к_весам_модели")tokenizer = AutoTokenizer.from_pretrained("путь_к_токенизатору")

2. Тонкая настройка (необязательно): если вы работаете с пользовательским набором данных, вам может потребоваться тонкая настройка модели.

Шаг 4: Запустите модель локально

После всех настроек вы готовы запустить DeepSeek-R1 локально.

1. Подготовьте входные данные: токенизируйте входные данные с помощью токенизатора.

inputs = tokenizer("Ваш входной текст здесь", return_tensors="pt")

2. Сгенерировать выходные данные: передать токенизированные входные данные в модель.

outputs = model(**inputs)

3. Постобработка: декодируйте вывод, чтобы получить текст, понятный человеку.

decoded_output = tokenizer.decode(outputs[0], skip_special_tokens=True)

Плюсы и минусы DeepSeek-R1

Плюсы:

- Экономичность: отсутствие платы за API, запуск бесплатно.

- Забота о конфиденциальности: все данные хранятся локально, что повышает безопасность.

- Мощное рассуждение: идеально подходит для сложных задач, требующих вдумчивости и планирования.

Минусы:

- Более медленное выполнение: поскольку модели рассуждений продумывают проблему шаг за шагом, ответы могут занять больше времени, чем у традиционных LLM.

- Требования к оборудованию: для более крупных моделей требуется более мощное оборудование, что может оказаться не под силу каждому.

Сравнительная таблица: DeepSeek-R1 и облачные решения

| Особенность | DeepSeek-R1 (локальный) | Облачные решения |

|---|---|---|

| Конфиденциальность данных | Высокий | Средний |

| Задержка | Низкий | Средний |

| Настройка | Полный контроль | Ограниченный |

| Расходы | Высокая начальная стоимость | Оплата по мере использования |

Рекомендации

Для тех, кто использует DeepSeek-R1 для кодирования или решения сложных математических задач, я рекомендую выбрать модель с 7 миллиардами или 14 миллиардами параметров для баланса производительности и использования ресурсов. Однако, если вы используете эту модель на ограниченном оборудовании (например, на бюджетном ноутбуке), модели с 1,5 миллиардами должно быть достаточно.